인간과 유사한 체계적 일반화가 가능한 메타 학습 신경망(MLC)

Abstract

인간의 언어와 사고의 힘은 체계적 구성성*(systematic compositionality)에서 비롯됩니다. 이는 알려진 구성 요소로부터 새로운 조합을 이해하고 생성하는 대수적 능력을 말합니다. Fodor와 Pylyshyn은 인공 신경망은 이러한 능력이 부족하며, 따라서 사고의 모델로 적합하지 않다고 주장했습니다. 신경망은 그 이후로 상당히 발전했지만, 체계성에 대한 도전은 여전히 남아 있습니다. 여기에서 우리는 신경망이 구성 능력에 대해 최적화되었을 때 인간과 같은 체계성을 달성할 수 있다는 증거를 제공함으로써 Fodor와 Pylyshyn의 주장에 성공적으로 대응합니다. 이를 위해 우리는 구성적 과제의 동적 스트림을 통해 훈련을 지도하는 메타 학습**을 위한 구성성(meta-learning for compositionality, MLC) 접근 방식을 도입했습니다. 인간과 기계를 비교하기 위해, 우리는 지시 학습 패러다임을 사용하는 인간 행동 실험을 수행했습니다. 일곱 가지 다른 모델을 고려한 후, 완벽하게 체계적이지만 유연하지 않은 확률적 기호 모델과, 완벽하게 유연하지만 체계적이지 않은 신경망과는 대조적으로, MLC만이 인간과 같은 일반화를 위해 필요한 체계성과 유연성을 모두 달성한다는 것을 발견했습니다. MLC는 또한 여러 체계적 일반화 벤치마크에서 기계 학습 시스템의 구성 능력을 발전시킵니다. 우리의 결과는 표준 신경망 아키텍처가 그 구성 능력에 대해 최적화될 때 인간의 체계적 일반화를 head-to-head 비교에서 모방할 수 있음을 보여줍니다.

*체계적 구성성(systematic compositionality): 알려진 요소들을 조합하여 새로운 개념이나 아이디어를 이해하고 생성하는 능력.

**메타 학습(meta-learning): 기계 학습에서 학습 과정 자체를 개선하는 방법론.

Figure

MLC를 통한 구성 능력 획득 방식

– MLC (Meta-Learning for Compositionality)는 구성적 과제의 동적 스트림을 통해 신경망의 구성 능력을 키우는 방법입니다.

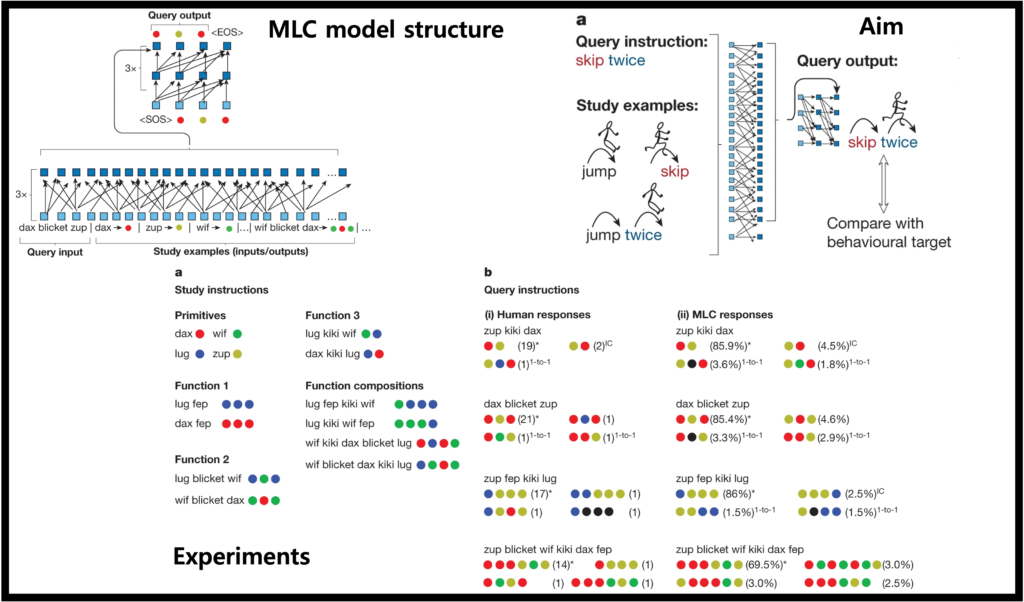

– Fig. 1.은 MLC가 어떻게 다양한 구성적 작업(에피소드)을 통해 신경망을 훈련시키는지 보여줍니다.

Fig. 1. 구성적 과제(에피소드)의 동적 스트림을 통해 MLC가 구성적 능력을 얻는 과정

(A) 훈련 과정 중, 에피소드 A는 신경망에 학습 예시와 쿼리 명령을 동시에 입력으로 제공합니다. 학습 예시는 ‘두 번 뛰기’, ‘건너뛰기’ 등을 어떻게 하는지를 보여주며, 입력과 해당 출력은 각각 단어와 텍스트 기반 동작 심볼(인형 그림을 안내하는 실선 화살표)로 제공됩니다. 쿼리 명령에는 연구 예시에서 오직 단독으로 제시된 단어(‘건너뛰기’)의 구성적 사용이 포함되어 있으며, 의도된 출력은 제공되지 않습니다. 신경망은 쿼리 출력을 생성하고, 이것은 행동 목표(두꺼운 화살표)와 비교됩니다.

(B) 에피소드 B에서는 ‘발끝으로 걷기’라는 새로운 단어(‘tiptoe’)가 소개되고, 신경망은 이를 구성적으로 사용하도록 요청받습니다(‘원뿔 주위로 뒤로 발끝으로 걷기’). 이런 방식으로 많은 추가 훈련이 계속됩니다.

가상 언어 구조에 대한 구성능력 비교 : 인간 vs MLC

– 가상 언어를 만들어 본 언어의 구조를 파악하는 문제를 제시함.

– 이를 통해 인간의 체계적인 구성능력이 어떻게 되는지 정량적으로 측정하였으며 이를 MLC와 비교하였습니다.

Fig. 2. 학습 예시(가상 언어)에 대해 추상적 결과(색이 다른 동그라미)로 출력하는 Few-shot instruction-learning task

(A) 학습 예시에 기반하여 인간과 MLC가 (B) 쿼리 명령에 어떻게 반응했는지 보여주는 그림. 가장 많이 답으로 제시된 4가지 case가 제시 되었으며(수는 해당 답을 제시한 사람의 수, %는 MLC의 답변 비율). *는 정답을 의미하며 one-to-one error (1-to-1) 과 an iconic concatenation error (IC)을 의미함. 검은 색 동그라미는 학습 예시에서 제시하지 않은 색을 정답에 제시한 경우

– Primitive에 function이 붙으면 output이 특정 규칙으로로 변한다

– fep은 앞에 있는 primitive를 세번 반복 (primitive fep)으로 묶임

– blicket은 앞 primitive를 앞뒤에 두고 뒤 primitive을 가운데에 둔다.

– kiki는 primitive의 순서를 바꿈

– 이 규칙에 의해 Function compositions를 해석할 수 있음

– 이 규칙을 파악해서 학습에 활용되지 않은 Query instructions를 맞추는 것을 목표

Open ended 학습에서의 구성능력 비교 : 인간 vs MLC

– 이전 실험과 다르게 학습 예시(input/output)를 보여주지 않고, 바로 response를 하게 함.

– 이 실험의 목표는 인간이 언어 습득에서 보이는 편향을 확인하기 위함

Fig. 3. Open-ended 학습 예시 실험

(A) 쿼리 명령에 대한 인간의 반응

(B) 쿼리 명령에 대한 MLC의 반응

참가자들은 어떠한 학습 사례도 보지 않고 질문(언어적 문자열)에 대한 응답(색깔 있는 원의 순서)을 생성했습니다. 각 열은 다른 참가자(a) 또는 MLC 샘플(b)의 다른 단어 할당과 응답을 보여줍니다. 가장 왼쪽 패턴(a와 b 모두)은 사람과 MLC 모두에게 가장 일반적인 출력이었음. 단어와 색깔 있는 원을 일대일(1-to-1) 대응 하며, 왼쪽에서 오른쪽 방식으로 쿼리를 변환(IC)하는 방식을 선호함. 가장 오른쪽 패턴(a와 b 모두)은 덜 명확하게 구조화되어 있지만 여전히 각 명령어에 대해 고유한 의미를 생성함(상호 배타성(ME)).

MLC 모델의 구조

Fig. 4. MLC 모델의 구조

일반적인 트랜스포머 인코더 구조이며 좌측 하단에 쿼리 명령을 넣고, 우측 하단에 학습 예시(입력/출력)를 입력한다. 학습 예시는 | 토큰으로 구분하며 일반적인 디코더(상단)에서 인코더의 정보를 받고 출력을 제시한다(색깔 동그라미). 다양한 에피소드를 활용하여 최적화 후 weights 값을 고정한 상태에서 트랜스포머는 다양한 tasks를 수행한다. 박스는 단어의 embedding vector을 의미한다

Disscussion

이 연구는 인간의 구성적 언어 능력을 모방하거나 능가하는 새로운 기계 학습 방법인 MLC(Meta-Learning for Compositionality)를 소개하고 있습니다. MLC는 표준 신경망이 인간과 유사한 체계적 일반화를 달성할 수 있도록 최적화되었습니다. 이 연구는 Fodor와 Pylyshyn이 제기한 체계성에 대한 논쟁에 대응하여, 인간과 기계의 언어 처리 능력을 직접 비교합니다. 실험 결과, 인간 참가자들은 체계적이고 대수적인 방식으로 반응하는 반면, MLC는 기존 신경망보다 더 강한 체계성과 더 미묘한 행동을 보였습니다. MLC는 메타-러닝을 통해 언어 처리의 체계성과 인간적 편향을 모두 재현하는 데 성공했으며, 이는 신경망 아키텍처의 고유한 특성이 아니라 데이터로부터 유도된 것입니다.

그러나 MLC는 Fodor와 Pylyshyn이 제기한 모든 도전을 해결하지는 못했습니다. MLC는 연습되지 않은 일반화 형태나 메타-러닝 분포 외의 개념을 자동으로 처리하지 못합니다. 또한, 메타-러닝 전략은 새로운 에피소드가 훈련 에피소드와 관련하여 분포 내에 있을 때 성공하지만, 메타-러닝 중에 제시된 에피소드와 관련하여 분포 외에 있는 에피소드에는 일반화하지 못합니다. 이 연구는 인간의 구성적 기술의 기원을 이해하고 현대 AI 시스템의 행동을 인간과 더 유사하게 만드는 데 메타-러닝의 가능성을 보여줍니다.